Le SEO (Search Engine Optimization) est une forme de manipulation des algorithmes qui régissent le comportement des moteurs de recherches tels que Google ou Bing. Ainsi, pour bien optimiser une page Web dans le but d’améliorer son positionnement, il convient d’abord de comprendre le fonctionnement de ces algorithmes.

Les paramètres qui boostent le SEO

Les algorithmes de référencement ne sont que des logiciels qui analysent les pages publiées sur le Web. Comme ces pages sont accessibles à tout un chacun, il est relativement aisé de les analyser et d’identifier les critères qui seront pris en compte par les moteurs.

Plus de 200 critères

D’après Google, et la communauté des référenceurs, ces critères seraient au moins au nombre de 200. Légende ou réalité ? Cela reste à démontrer. En revanche, ce dont nous sommes certains, c’est que quelques critères sont bien plus importants que d’autres. En d’autres termes, y prêter un grande attention améliorera nettement le trafic d’un site.

Regroupons-les en 4 familles :

- La qualité technique du site

- La qualité du contenu

- La satisfaction de l’internaute

- La notoriété du site

La qualité technique du site influe sur son référencement naturel

C’est un fait établi : la qualité technique d’un site Web impacte directement sur ses performances en termes de SEO. Ainsi, un site mal codé ou mal hébergé n’a que peu de chance de bien se positionner dans les pages de résultats des moteurs (SERP).

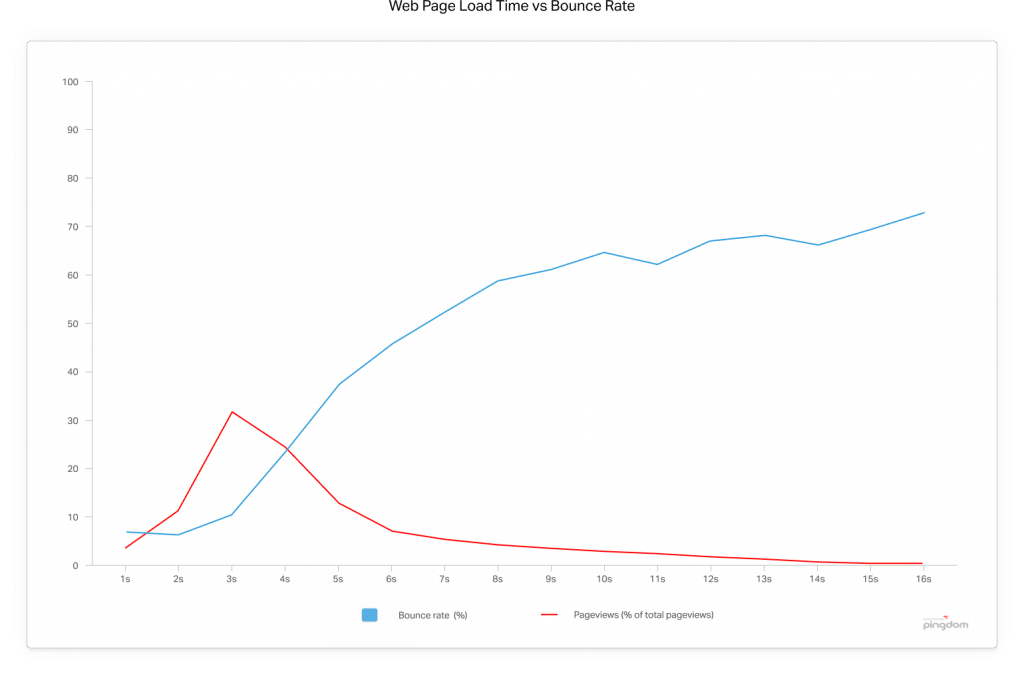

La vitesse de chargement d’une page influe sur son référencement mais également sur le comportement des utilisateurs.

La qualité du contenu est un pilier du SEO

Il ne faut jamais perdre de vue que la raison d’être d’un site Web est son utilité pour les internautes. Or, nous savons que les usagers d’Internet utilisent d’abord un moteur de recherches pour répondre aux questions qu’ils se posent. Nous savons également qu’en B2B, les entreprises qui cherchent un nouveau fournisseur commencent leur recherche par un moteur de recherches, essentiellement Google. Et, ils sont plus de 80% à dire procéder de cette façon !

On voit donc que la qualité de la réponse donnée à une question posée par les internautes est un critère important, pour ne pas dire capital. Content is king !

La satisfaction de l’internaute : le Graal du webmaster

Si une page répond parfaitement aux deux critères ci-dessus, il y a de bonnes chances pour qu’elle donne satisfaction à ses visiteurs. Si les visiteurs sont contents, Google le sera aussi, soyez-en persuadés ! Ainsi, nous pouvons affirmer que performance et pertinence sont les deux mamelles du référencement naturel !

La notoriété du site : pour être lu, un site doit être vu !

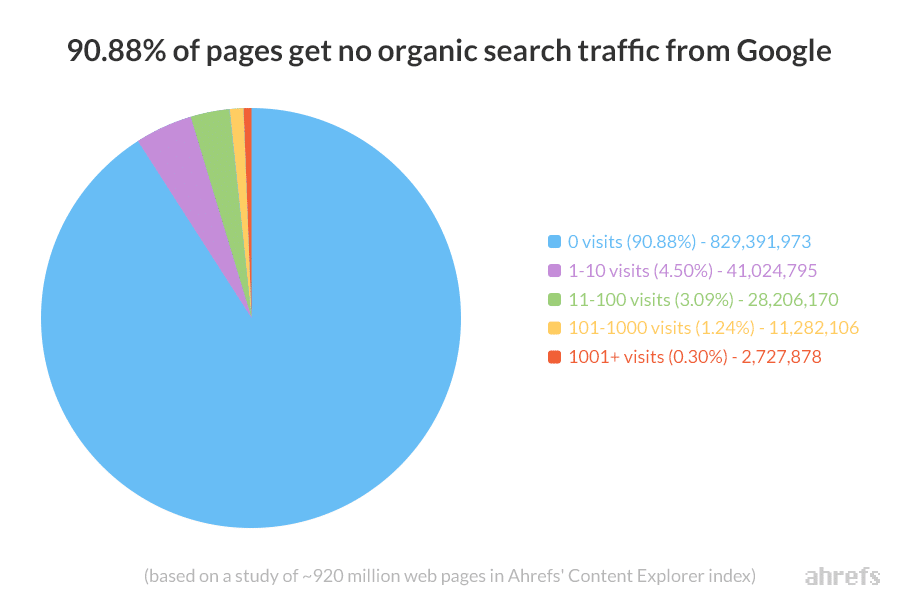

Cela paraît tellement évident. Et pourtant, près de 91% des pages publiées sur Internet ne reçoivent aucune visite provenant des moteurs de recherches car elles ne sont simplement pas visibles !

Comment optimiser le SEO d’un site ?

Simplement, en améliorant les quatre critères que je viens de décrire. Ce n’est pas plus compliqué que cela !

Alors, voyons le processus en détail et point par point.

Améliorer la qualité technique du site Web

Pour atteindre une qualité technique qui va répondre aux exigences de Google, il y a deux éléments importants à prendre en considération : le code et l’hébergement.

Le code

Un code de bonne facture, bien structuré et optimisé sera un véritable levier pour le SEO. Il est capital de faire appel à de vrais professionnels qui ne savent pas uniquement coder, mais qui comprennent et intègrent les “Google guidelines” dans leur travail. L’usage d’un CMS tel que WordPress est souvent une bonne solution, à condition de savoir l’optimiser.

L’hébergement

Un serveur rapide est une des clés indispensables pour le succès d’un site. Et cela suppose de bannir impérativement le recours à des serveurs mutualisés low-cost qui pénalisent le site plus qu’ils ne lui rendent service !

Un bon hébergement a un coût. Et, faire des économies sur ce poste est une très mauvaise idée.

Même si je préfère le taux de conversion, un bon indicateur de la qualité d’un hébergement est le taux de rebond, comme le montre l’étude de PingDom.

Rédiger un contenu pertinent et utile

Structure, pertinence et lisibilité

Pour un algorithme, analyser un contenu écrit est relativement plus simple que d’analyser une image, une vidéo ou un fichier audio. Mais, plus simple ne veut pas dire plus facile.

Ainsi, pour aider les Googlebots a bien travailler, Google recommande de bien structurer les textes publiés en utilisant des balises HTML spécifiques. Pour ce faire, il est fortement recommandé de bien organiser sa pensée et ses objectifs avant de prendre la plume.

Ensuite, il est important de répondre aux questions que se posent réellement les internautes. Fini le temps où il suffisait de choisir le “bon mot-clé” ! Dorénavant, il convient de détecter quelles sont les intentions, pas forcément toujours exprimées, qui se cachent derrière les requêtes des internautes afin d’être en mesure de leur proposer en retour la réponse la plus pertinente et le plus complète possible.

Enfin, la lisibilité devient un critère de plus en plus important. D’autant, qu’il est lui aussi mesuré par Google. La ponctuation, la fluidité du texte, la présence de point de rupture (en positionnant des images dans le texte), la taille et le style des polices utilisées et le contraste entre la couleur du texte et celle du fond sont autant de points sensibles qu’il faut surveiller.

Surveillez ces critères, faute de quoi, les KPI de Google ne vous feront pas de cadeau !

SECRETS DE WEBMASTERS

Recevez nos trucs et astuces pour booster votre business digital.

La satisfaction de l’internaute

Un bon contenu, utile et pertinent qui est bien hébergé sur un serveur rapide ne pourra que donner satisfaction à ses lecteurs. Il faut donc impérativement suivre la satisfaction des utilisateurs d’un site Web afin d’en identifier les faiblesses et de les corriger.

Pour bien répondre aux questions des internautes, il faut les connaître. C’est à ça que sert le data marketing appliqué au SEO.

N’oublions pas que le premier objectif d’un site Web n’est pas de faire plaisir à son éditeur, ou à ses concepteurs, mais bel et bien au public qu’il vise !

Améliorer la notoriété d’une page Web

On parle souvent de visibilité. Mais, la visibilité d’une page – rappelons-le, Google référence des pages et non des sites – n’est que la conséquence du travail de référencement dont nous parlons ici. Souvent, lorsqu’on entend parler de visibilité, il faut comprendre notoriété.

Cette notoriété est la résultante de deux phénomènes : la popularité de la page sur les autres sites Web via des liens hypertextes (on parle de backlinks) et la popularité du nom de domaine du site (marque).

Le netlinking ou l’art d’attendre des liens entrants qui tardent à arriver

La notoriété d’une page est la base du fonctionnement de Google. La mesure de cette notoriété peut se diviser en deux critères : le nombre de liens hypertextes qui pointent vers cette page et l’indice de confiance que Google accorde à ces liens.

La quantité de liens entrants et leur qualité est donc probablement LE critère le plus important en SEO.

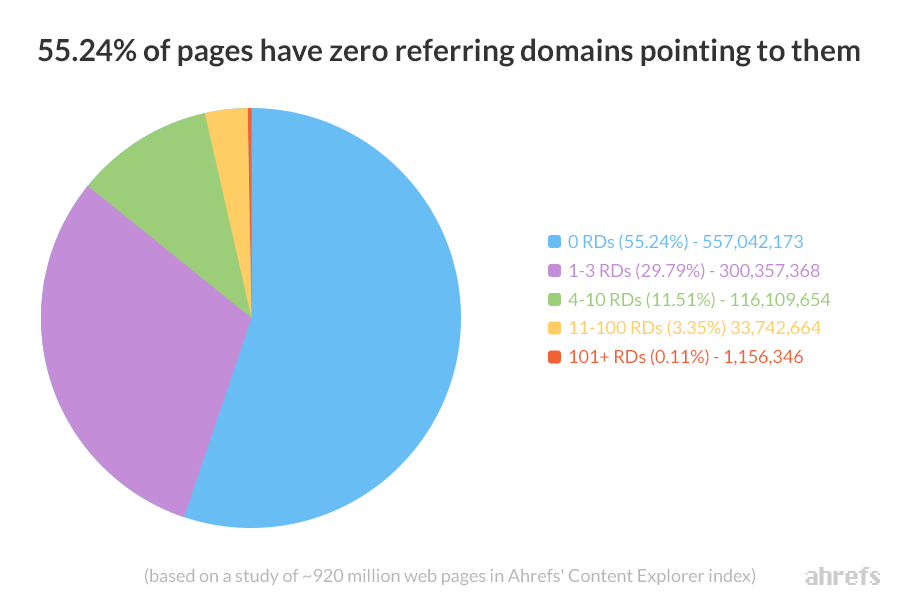

Pourtant, selon une étude de HREFS, plus de la moitié des pages publiées sur Internet ne reçoivent aucun lien…

On peut attendre, parfois fort longtemps, pour qu’un site tiers se décide à créer un lien vers une page de votre site. Bien évidemment, plus votre page sera de qualité (cf ci-dessus), plus ce lien, et d’autres, arriveront vite. On appelle cette méthode le linkbaiting.

On peut aussi provoquer la chance et acquérir des liens de différentes façons : les échanger (backlinking), les acheter ou les créer sur d’autres sites vous appartenant. Toutes ces méthodes sont bannies par Google, seulement… si on se fait attraper !

Pour un netlinking qualitatif et raisonné

Le secret pour “tricher” sans se faire attraper est de simuler le plus possible le linkbaiting naturel en respectant quelques règles.

- Le nombre de liens entrants doit être réaliste et fonction de l’âge du site. Les liens doivent être issus de plusieurs noms de domaine avec une bonne notoriété (Trust Rank / Trustflow).

- Les pages qui font un lien doivent travailler le même champ lexical que celui de la page ciblée.

- Il est préférable que les liens soient positionnés à l’intérieur d’un texte plutôt que dans un footer ou une sidebar.

- L’ancre du lien hypertexte (le mot souligné) doit sembler naturelle. Google punit sévèrement les ancres sur-optimisées (celles qui sont constituées du mot-clé “qui va bien”).

Le maillage interne

L’autre usage du netlinking est tourné vers les liens hypertextes qui relient les pages d’un même site entre elles. On parle de maillage interne. Ce moyen est très utile pour aider l’internaute à naviguer sur le site, mais également pour contextualiser une page dans son champ lexical.

Le maillage interne est donc un excellent moyen, simple et rapide, de travailler le référencement d’un site. Il est malheureusement trop souvent négligé.

Et les réseaux sociaux dans tout ça ?

La présence d’une page sur les réseaux sociaux n’a pas d’impact direct sur le netlinking. Mais, cela permet d’améliorer la notoriété du nom de domaine et donc de la marque.

Cela permettra également d’attirer des visiteurs qualifiés, ce qui aura, indirectement, un impact sur le SEO. En effet, si vous visez la bonne audience, il est fort probable que l’article proposé sera mieux lu, ainsi ses KPI s’en trouveront améliorés. Ce qui enverra un excellent signal à Google.

Et, puis certains lecteurs ciblés pourraient faire un lien vers l’article partagé en reprenant le thème abordé sur leur propre blog ou site.

Améliorer la notoriété du domaine dans la vraie vie

Google ne dispose pas, du moins pour le moment, de moyens efficaces pour évaluer la notoriété d’un nom de domaine à l’extérieur du Web. Son unique moyen d’évaluer ce critère est de mesurer le nombre de fois où le nom de domaine est directement entré dans Google ou dans Chrome (voir cité dans Gmail).

Alors il faut penser, dès que l’occasion se présente, à communiquer sur le nom de domaine pour inciter ses interlocuteurs à l’entrer directement dans le moteur de recherches. Plus il y en aura, plus Google pourra se dire que ce nom de domaine a une forte notoriété et il réagira en conséquence.

Référencement naturel : c’est un métier !

Vous avez compris que toutes les étapes à franchir pour satisfaire aux exigences de Google demandent des compétences pointues. C’est également un processus chronophage et sans fin.

Pour qu’un site soit rentable, il est indispensable qu’il soit parfaitement référencé. Alors, il n’existe que deux possibilités pour y parvenir : la formation ou la prestation.